LLM压缩技术梳理大模型压缩技术简要解释

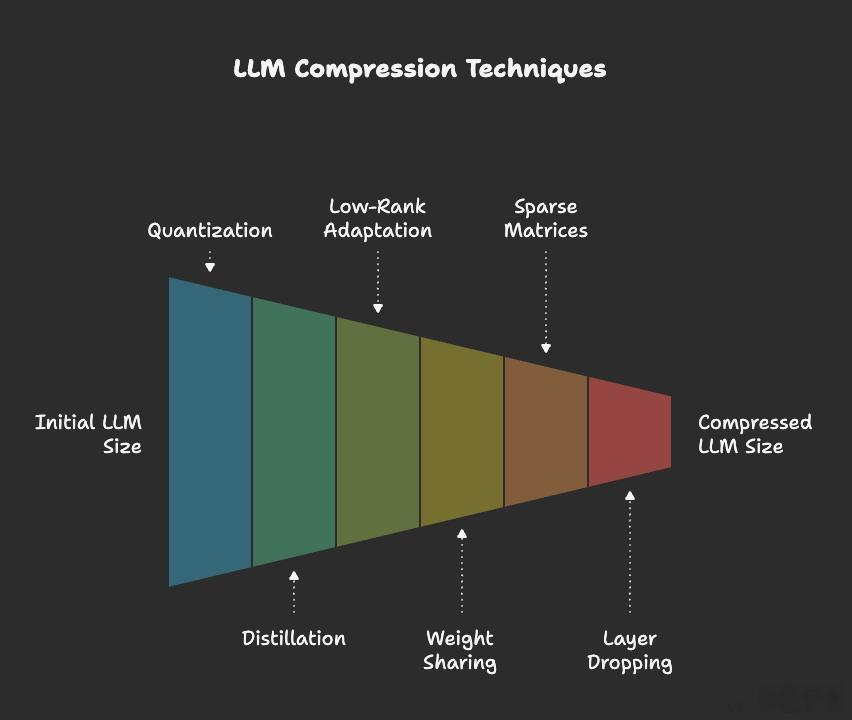

梳理一下LLM压缩技术。这些方法各有优势,也可组合使用。

量化(Quantization):将权重、激活值乃至KV缓存从高精度(如FP16/FP32)压缩至低比特(如8/6/4/3/2 bit),可显著降低显存占用与带宽开销。最新研究系统评估了不同量化方式在多种模型结构与任务下的表现,结果显示在精度基本保持的前提下,低比特量化可带来可观的吞吐率提升与成本下降,因而成为LLM落地过程中最常用的压缩路径之一。

知识蒸馏(Knowledge Distillation):通过大模型(Teacher)生成的软标签或分布信息,引导小模型(Student)学习其行为和知识,从而以更少的参数实现接近性能。在LLM时代,KD不仅用于压缩和提速,也被广泛应用于自蒸馏与对齐强化,方法上区分为黑盒与白盒两类。

低秩适配/分解(Low-Rank Adaptation, LoRA / Low-Rank Factorization):通过在原始大矩阵中插入可训练的低秩分解矩阵,并冻结原始权重,使训练与存储参数大幅减少。此类方法不仅适用于压缩,同时也是高效微调的核心策略之一;适配后权重可与基模型合并,推理时几乎不增加延迟。

稀疏化/剪枝(Sparsity / Pruning):通过移除对模型输出影响较小的连接或通道,使权重矩阵变得稀疏,进而减少参数总量与计算负担。例如SparseGPT展示了对GPT家族模型一次性剪枝至≥50%稀疏度而几乎无精度损失,为结构化与非结构化剪枝提供了有效路径。

参数共享(Weight Sharing):在不同层间复用同一组参数,以降低模型总参数量与内存占用。典型如ALBERT中采用跨层参数共享与分解式嵌入结构,在不显著损失表示能力的前提下大幅压缩参数量。这一思路已被后续多种Transformer/LLM架构广泛吸收。

层丢弃/深度可调(Layer Dropping / Depth-on-Demand):通过结构化Dropout对模型层级进行正则化,训练后在推理时可按需选择子网络的深度,从而灵活平衡推理延迟与性能。例如LayerDrop技术表明,在无需额外微调的情况下,可根据任务需求动态调整模型深度,适用于延迟敏感场景。