【AI数学能力之争:移动的终点线与真实的进步】

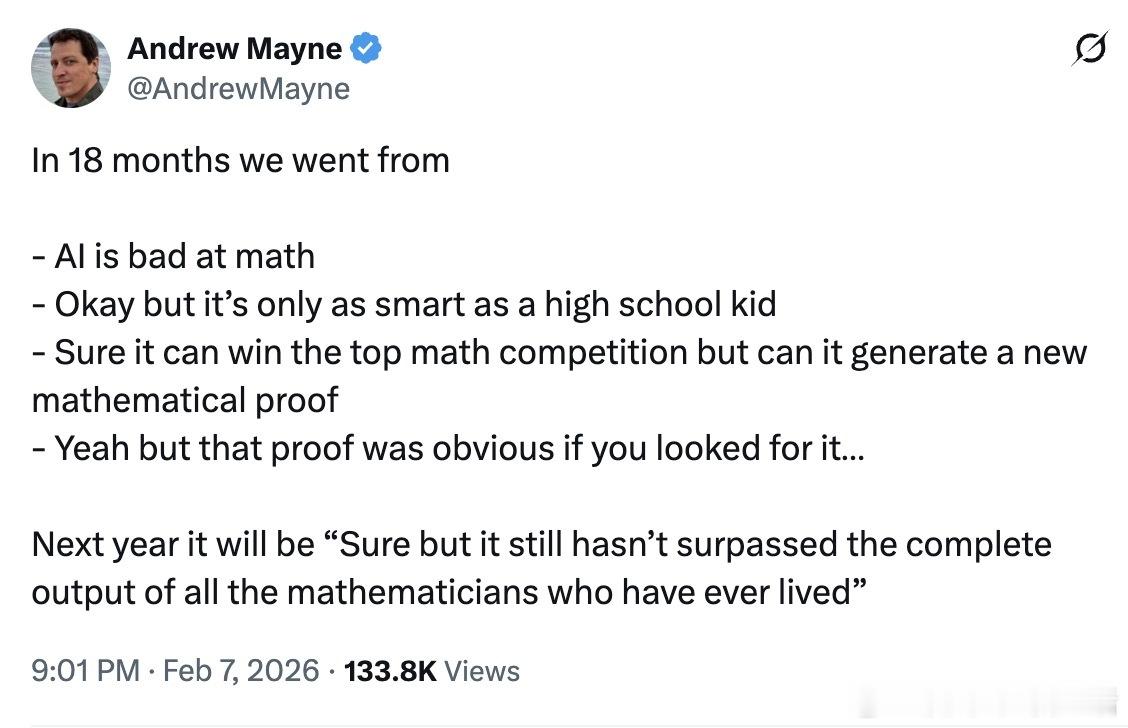

OpenAI员工Andrew Mayne发了一条推文,梳理了过去18个月里人们对AI数学能力的态度变化:从“AI不会做数学”,到“只有高中生水平”,到“能赢数学竞赛但不能生成新证明”,再到“那个证明太显然了”。他预测下一个说法会是“但它还没超过人类数学家的全部产出”。

这条推文在Reddit引发了一场精彩的混战。

支持者指出,前沿模型在AIME测试上已经能拿到90%以上的分数,而大多数人连一道题都答不出来。更关键的是,2026年刚发布的AIME新题也被攻克了,这意味着不是靠背答案。陶哲轩、小野等顶级数学家都在认可AI的数学贡献,而很多数学研究生还停留在“AI不会做数学”的认知里。

反对者的论点同样有力。有人指出,LLM本质上是统计近似,无法进行确定性运算。两周前Gemini还在同一个回答里说100万纳秒既等于1微秒又等于1000微秒。GPT直到最近才搞清楚0.9比0.11大。这种低级错误在任何严肃任务中都不可接受。

最有意思的是关于“工具调用”的争论。AI做数学其实是靠调用计算器和Python脚本,这算真正的数学能力吗?一派认为这是作弊,真正的智能应该内生地理解数学。另一派反驳说,人类不也用计算器吗?知道何时使用正确的工具本身就是智能的一部分。

这里有个被忽视的关键区别:算术和数学是两回事。LLM确实不擅长精确计算,但数学远不止于此。就像有人说的,拉马努金也不是靠精确计算出名的,他擅长的是发现数学模式和联系。

一位艺术家的留言让人印象深刻:作为创作者,这几年是他人生中最糟糕的时期。他花了多年磨练技艺,现在艺术被贬值到写个提示词就能自称画家的地步。这种焦虑在程序员群体中同样蔓延,只是现在“AI不会写代码”的说法已经站不住脚,他们开始转向“AI不会做编码之外的工作”。

有人提出了一个精准的比喻:乔布斯说电脑是思维的自行车,那AI更像喷气式飞机。创新吗?当然。有用吗?在某些场景下无可替代。但什么事都用它,既浪费又污染。

真正值得思考的问题是:AI在数学上的突破,究竟是通用智能的体现,还是针对特定任务砸钱优化的结果?怀疑者说,这些系统最好的情况也只是逼近人类知识的边界,从未真正超越。支持者说,你们的终点线一直在移动。

也许两边都对。进步是真实的,局限也是真实的。问题在于,我们是在见证通往通用智能的道路,还是在见证一系列越来越精巧的专用工具的诞生。

这个答案,可能18个月后会更清晰一些。

reddit.com/r/OpenAI/comments/1qzdcgi/18_months