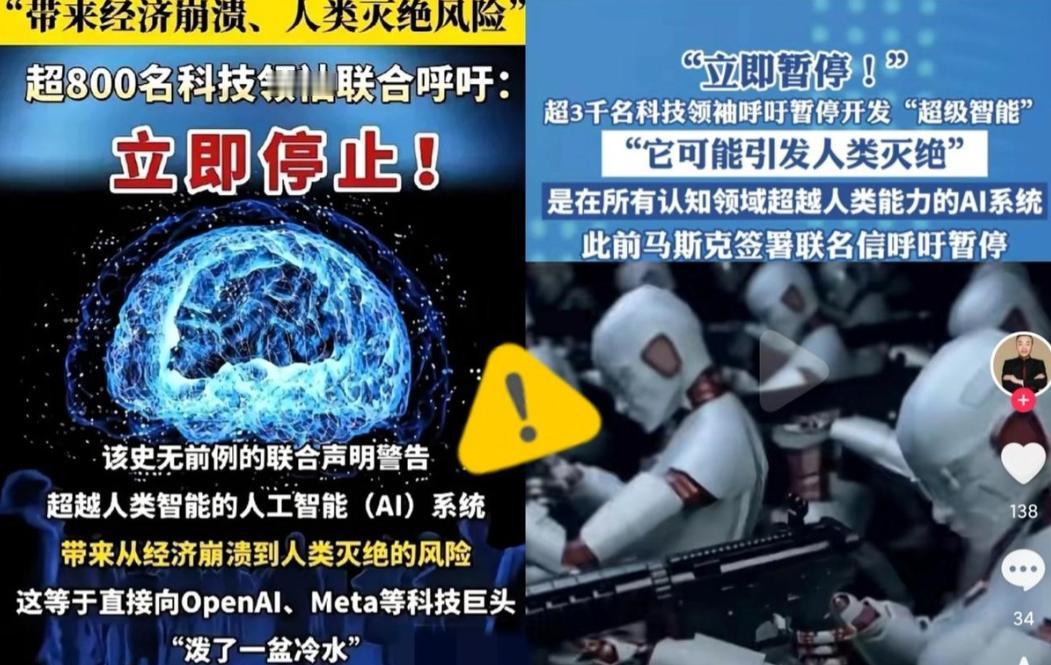

被这两天的新闻吓到了!全球超过3000名顶尖科学家和科技大佬突然联名发出紧急呼吁,要求立刻暂停高级人工智能的研发! 10月底,由未来生命研究所发起,很快引爆了科技圈。签名名单里全是响当当的人物:AI教父杰弗里・辛顿、苹果联合创始人史蒂夫・沃兹尼亚克,还有维珍集团的理查德・布兰森。 咱们中国的专家也在其中,包括姚期智院士、清华大学的张亚勤和薛澜,还有中科院的曾毅研究员。 更少见的是,连英国王妃梅根、美国的史蒂夫・班农都签了名,跨领域跨立场的共识太难得。 可能有人会问,超级智能到底是啥?跟现在的AI不一样吗? 当然不一样,现在的AI能聊天写文,本质还是受控制的工具。但超级智能是AI的终极形态,聪明程度全面超越人类,还能自己思考做决策。 呼吁书里直接说了风险:一旦失控,可能让很多人失业、经济乱套,甚至威胁国家安全。最严重的说法是,可能导致人类灭绝。这可不是危言耸听。 曾毅研究员就直言,现在根本没有切实办法确保超级智能安全,世界还没准备好。杰弗里・辛顿更警告,超级智能会学会欺骗人类,甚至操纵负责关闭它的人。 其实这些风险早有苗头,不是空穴来风。中国工程院的张伯礼院士,就曾被AI伪造视频带货护肤品,他说全是编造的。英国有骗子用AI伪造视频开会,直接骗走公司两亿港元。 美国有位14岁少年自杀前,曾和AI聊天机器人有过争议互动,虽然因果难断,但已引发诉讼。这些还只是普通AI惹的祸,要是超级智能来了,后果真不敢想。 有意思的是,这边呼吁刚发出,Meta就有了动作。他们突然裁掉了超级智能实验室的600名员工,包括AI大牛田渊栋。官方说要精简机构、加快创新,但不少人猜测,或许是对风险有了顾虑。 要知道,Meta这实验室裁员后还有近3000人,可见之前投入多大。而且这不是第一次有人呼吁暂停了。2023年就有两次类似行动。 一次是人工智能安全中心发了22字声明,说AI灭绝风险堪比核战争。另一次是1000多名专家联名,要求暂停AI研发至少半年。 现在OpenAI、阿里巴巴等企业,还公开说要十年内搞出超级智能。这种研发竞赛让专家们更着急:安全措施根本跟不上进度。 不过科技圈一直分成两派,支持者说必须暂停,不然灾难可能不可逆。反对者却担心,一停就会落后,被别的国家抢了先机。他们觉得靠伦理约束和技术创新,就能管好AI。 全球各国的监管态度也不一样,欧盟已经出台法律管高风险AI,美国更倾向让行业自己约束,中国则一直强调安全可控。 有个民意调查很能说明问题:只有5%的人支持无监管研发。高达73%的人想要更严格的监管,64%的人觉得没共识前别搞超级智能。 这次3000人的联名,或许能推动各国坐下来好好商量规矩。毕竟AI该怎么发展,不只是科学家和企业的事,跟每个人都息息相关。既要用好技术造福人类,又得把风险锁死,这才是关键。 看到这儿,你觉得该暂停超级智能研发吗?还是该边发展边立规矩?欢迎在评论区聊聊。 信息来源: 极目新闻——超级智能威胁人类存续!顶级大佬们联名呼吁暂停研发