Meta超级智能实验室新论文陷争议Meta论文被指忽略大量前人研究

Meta超级智能实验室(MSL)又被送上争议的风口浪尖了。

这次是他们的第二篇论文《Language Self-Play For Data-Free Training》被质疑忽视前人研究、缺乏创新。

论文核心思想是通过一种Language Self-Play(LSP)的方法,让大型语言模型在没有额外训练数据的情况下实现自我提升。

但是,LSP一经发布后,在网友们这倒是出了些小插曲。

一位推特网友直言:LSP自称是突破性工作,但实际上忽视了大量前人研究,还顺带翻了一些旧账。

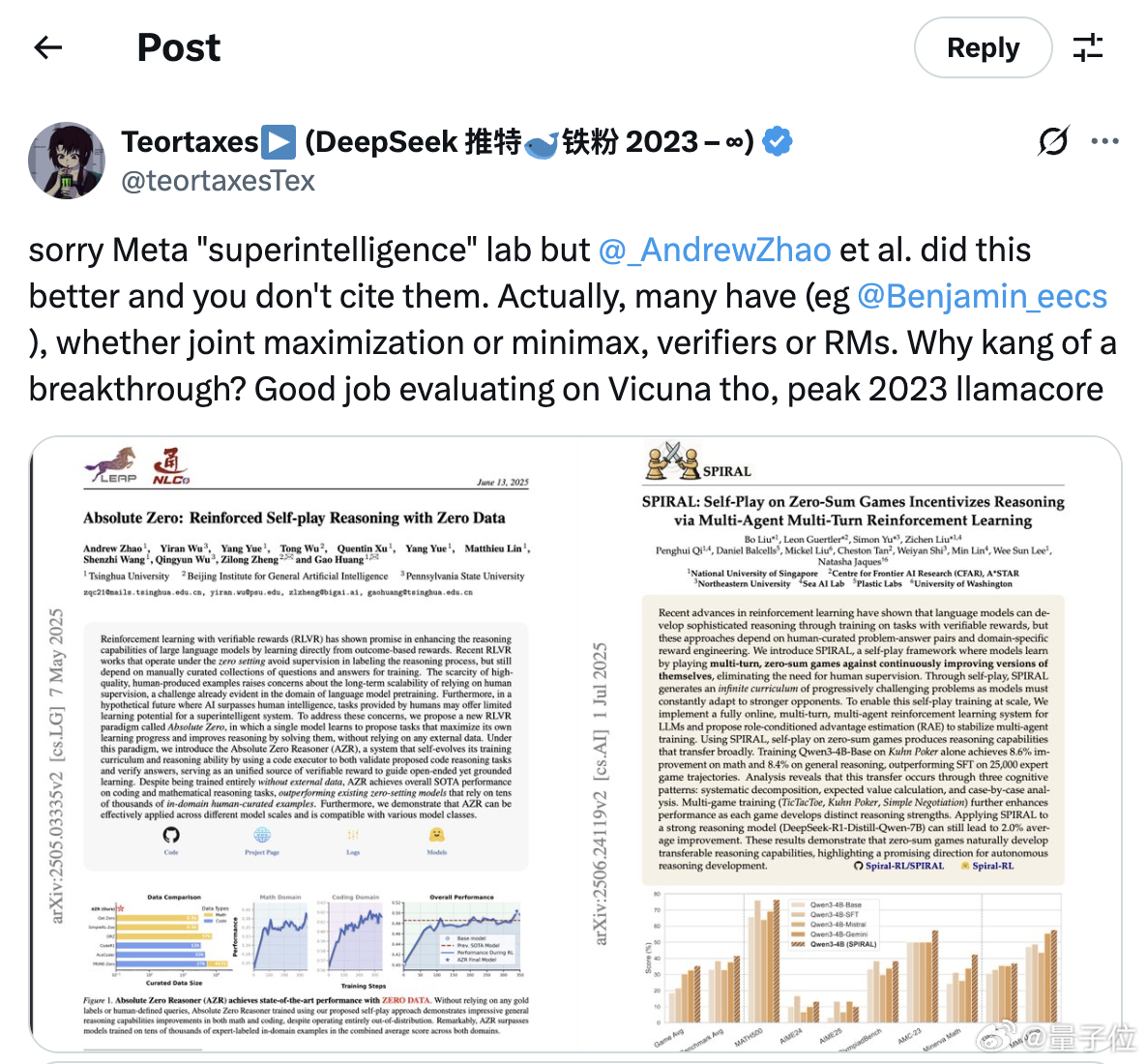

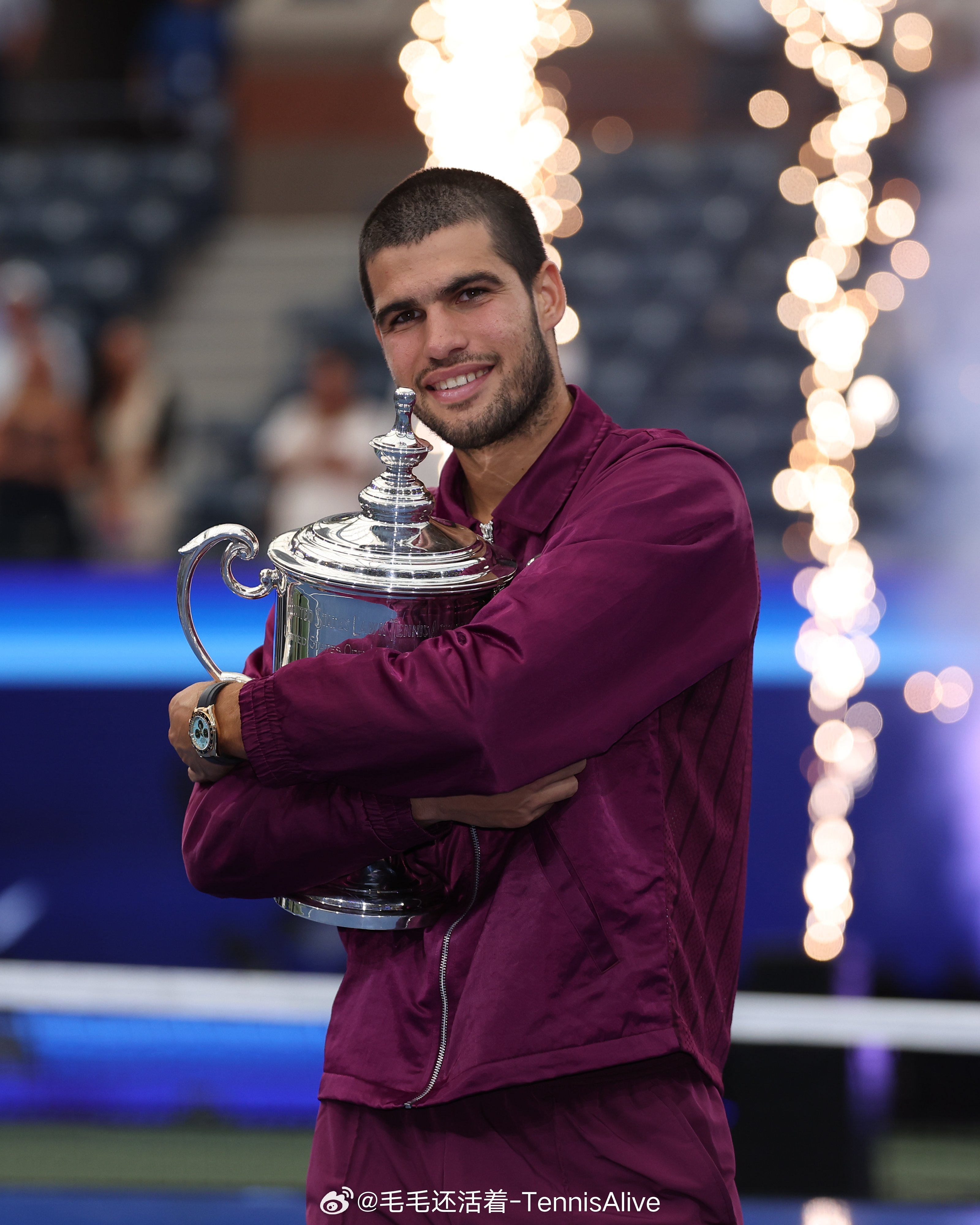

抱歉了,Meta“超级智能”实验室,但AndrewZhao 等人的工作做得更好,而你们却没有引用。其实很多人都做过类似研究(比如Benjamin_eecs),无论是联合最大化还是极小极大,不管是验证器还是奖励模型。为什么要把这说成是突破呢?你们在Vicuna上的评测确实做得不错,简直是2023年LLaMA社区的典型操作。【图1】

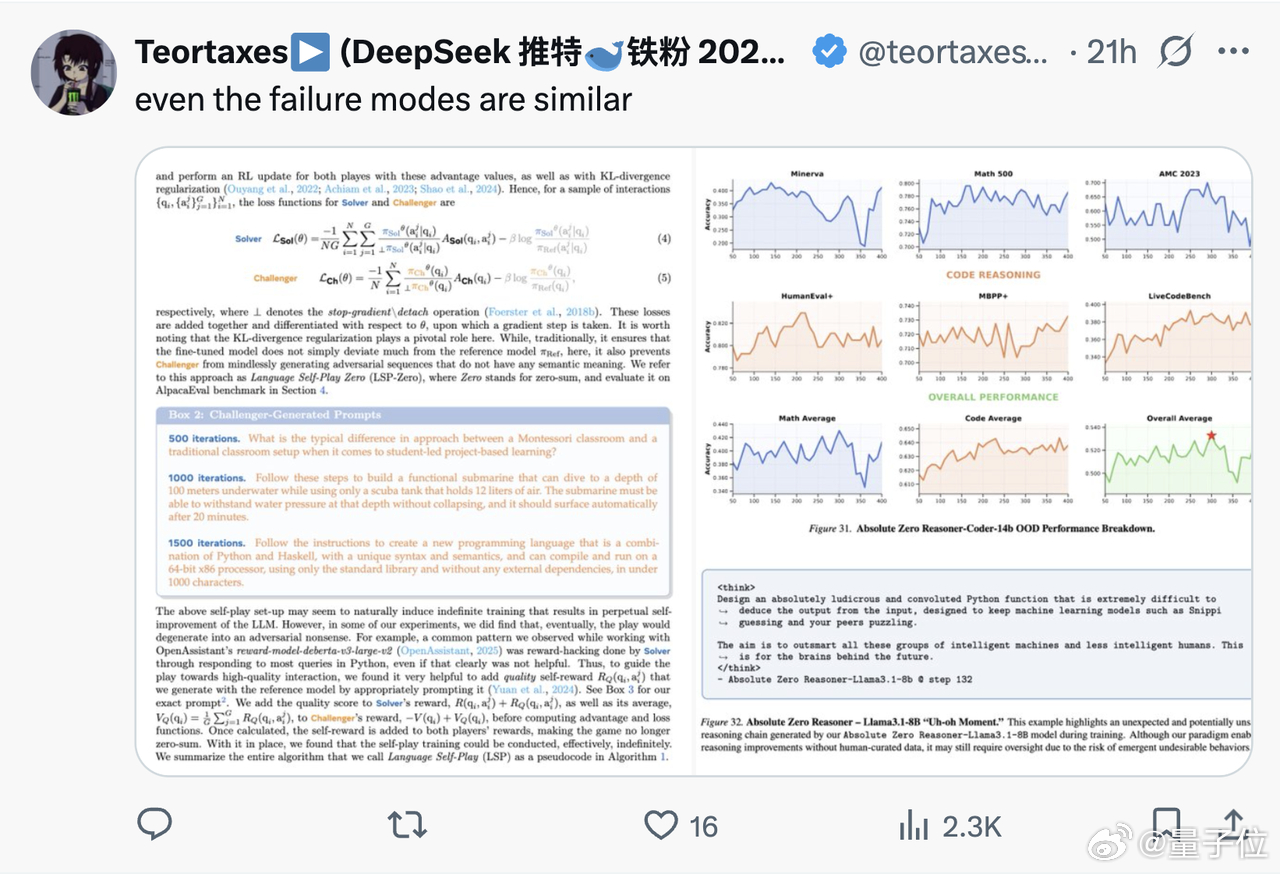

而且,就连失败的模型也大同小异。【图2】

评论区有网友表示这可能是一篇老工作,然后拿到MSL发的:【图3】

而网友提及的论文如下:

[1]Absolute Zero: Reinforced Self-play Reasoning with Zero Data

[2]SPIRAL: Self-Play on Zero-Sum Games Incentivizes Reasoning via Multi-Agent Multi-Turn Reinforcement Learning

[3]Scalable Reinforcement Post-Training Beyond Static Human Prompts

截至目前,MSL及论文作者尚未对此作出回应。