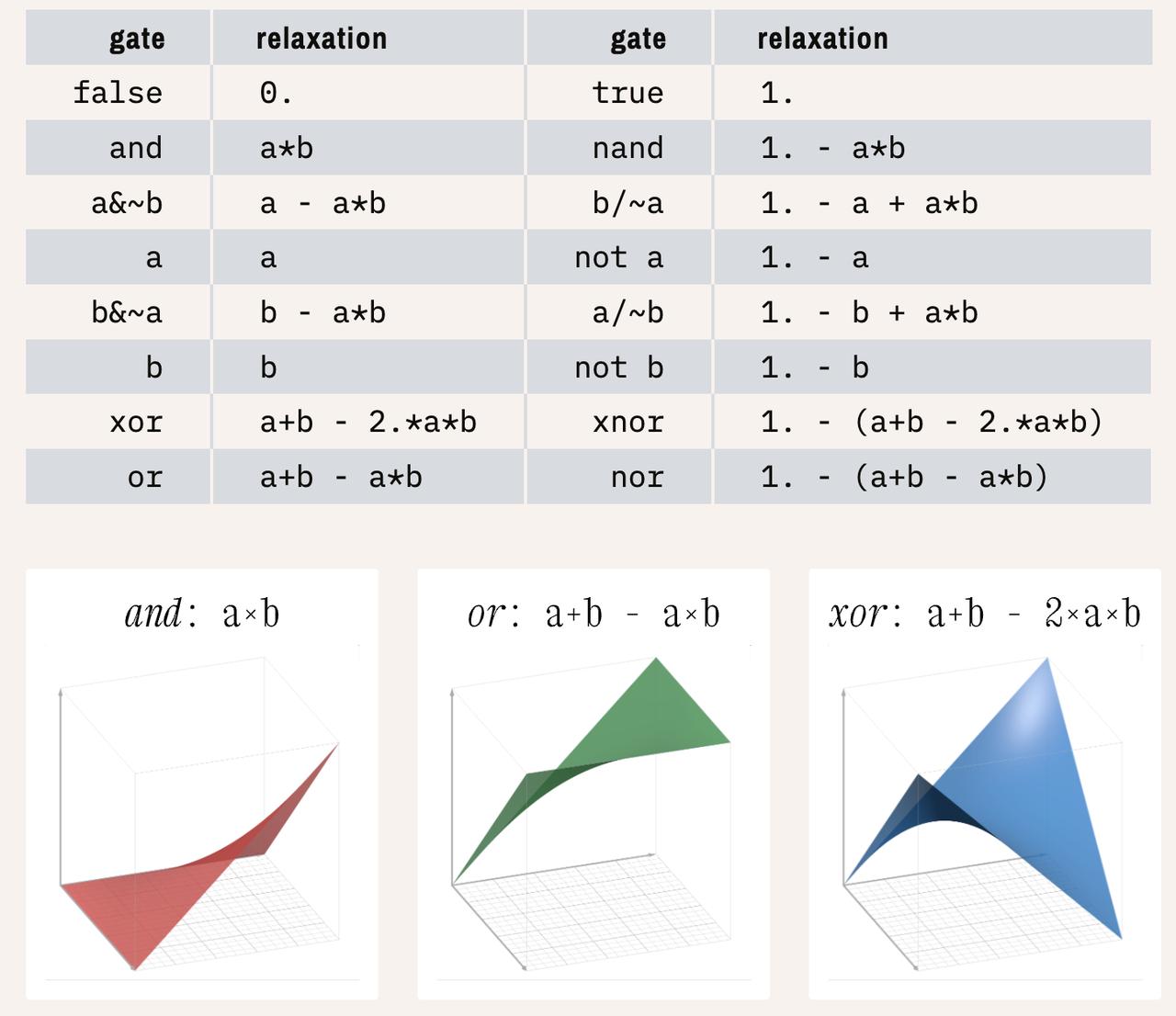

有开发者搞了个非常硬核的实验:他把一个神经网络“编译”成了C语言,结果推理速度直接提升了1744倍。 具体来说,他做了这些事: - 训练了一个神经网络去“学会”康威生命游戏里的3x3局部规则; - 不同于普通神经网络用ReLU激活函数,他把每个节点的激活函数换成了可训练的逻辑门组合(比如and、or、xor这些); - 训练完成后,他用代码把这个“逻辑门神经网络”抽象成一个纯逻辑电路; - 最后,这个电路被转换成300多行的C代码,支持bit-level并行运算。 这波操作的目的,是用传统C语言代码来跑神经网络推理,避免浮点运算、大量内存和GPU开销,最终用一个bit并行的`uint64_t`类型来一次性计算64个cell,大大提高了效率。 这背后其实是一个叫“Differentiable Logic Gate Networks(DLGN)”的研究方向,就是把神经网络里的“学权重”变成“学逻辑门组合”,再通过连续松弛方法(continuous relaxation)把逻辑门也变成可微分的,方便训练。训练完以后,再硬选一个最优逻辑门,把整个网络“离散化”。 有网友表示,以后就是“神经网络负责学,C语言负责跑”的思路了。 完整内容可以看这里: