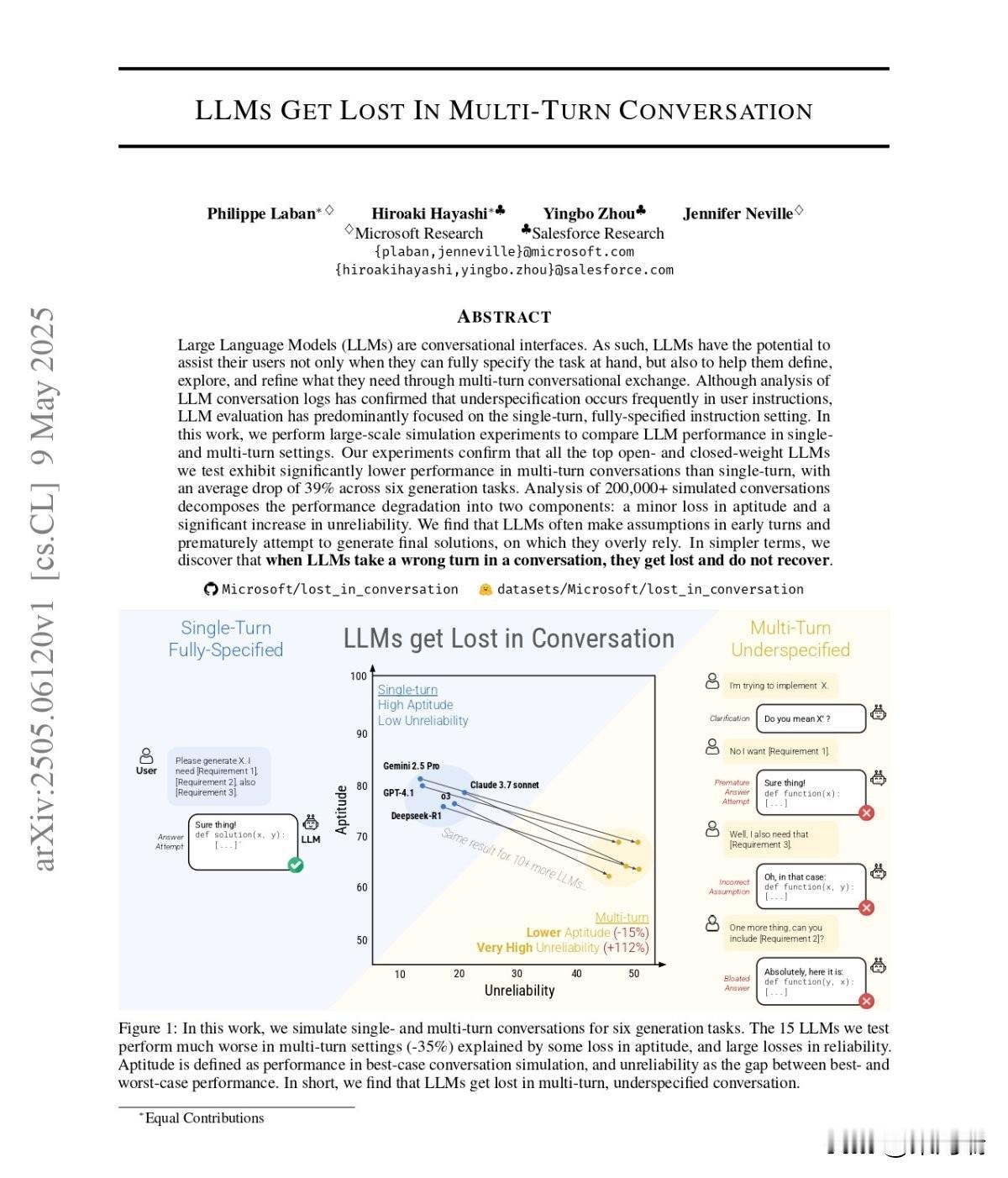

微软研究院(Microsoft Research)和 Salesforce 共同发布了一篇题为《LLMs Get Lost In Multi-Turn Conversation》(大模型在多轮对话中迷失)的重磅论文,该研究揭示了一个令开发者不安的现状:即便是当前最顶尖的 LLM,在应对真实世界的多轮对话时,可靠性会出现“断崖式”下跌。 该研究的主要发现包括: 性能下降:在单轮提示词下表现接近 90% 的模型,在经过多轮对话模拟后,平均性能大幅下降约 39%,跌至 65% 左右。 不可靠性增加:性能下降的主要原因并非模型“智力”(能力仅下降 15%),而是不可靠性增加了 112%。 “路径依赖”:模型往往在对话初期就做出错误假设,并将其锁定。一旦在对话中“走错一步”,模型会倾向于固守错误而非自我修正,最终导致彻底迷失。 测试模型:研究测试了包括 GPT-4.1、Gemini 2.5 Pro、Claude 3.7 Sonnet、o3、DeepSeek R1 和 Llama 4 在内的 15 款模型。具备强大推理能力的 o3 和 DeepSeek R1 在多轮可靠性上也未能幸免,单纯增加思考时间或降低随机性(Temperature=0)并不能解决问题。 对开发者的建议: 改进提示策略:尝试在首条消息中提供更完整的上下文和所有约束条件,而不是依赖多轮往返。 强制重置机制:在对话陷入僵局时,引导用户启动新会话,或通过自动摘要功能将关键信息带入新对话,而不是在旧会话中持续纠错。 多轮基准测试:建立针对多轮对话的可靠性评估流程,不要被单轮 Benchmark 迷惑。