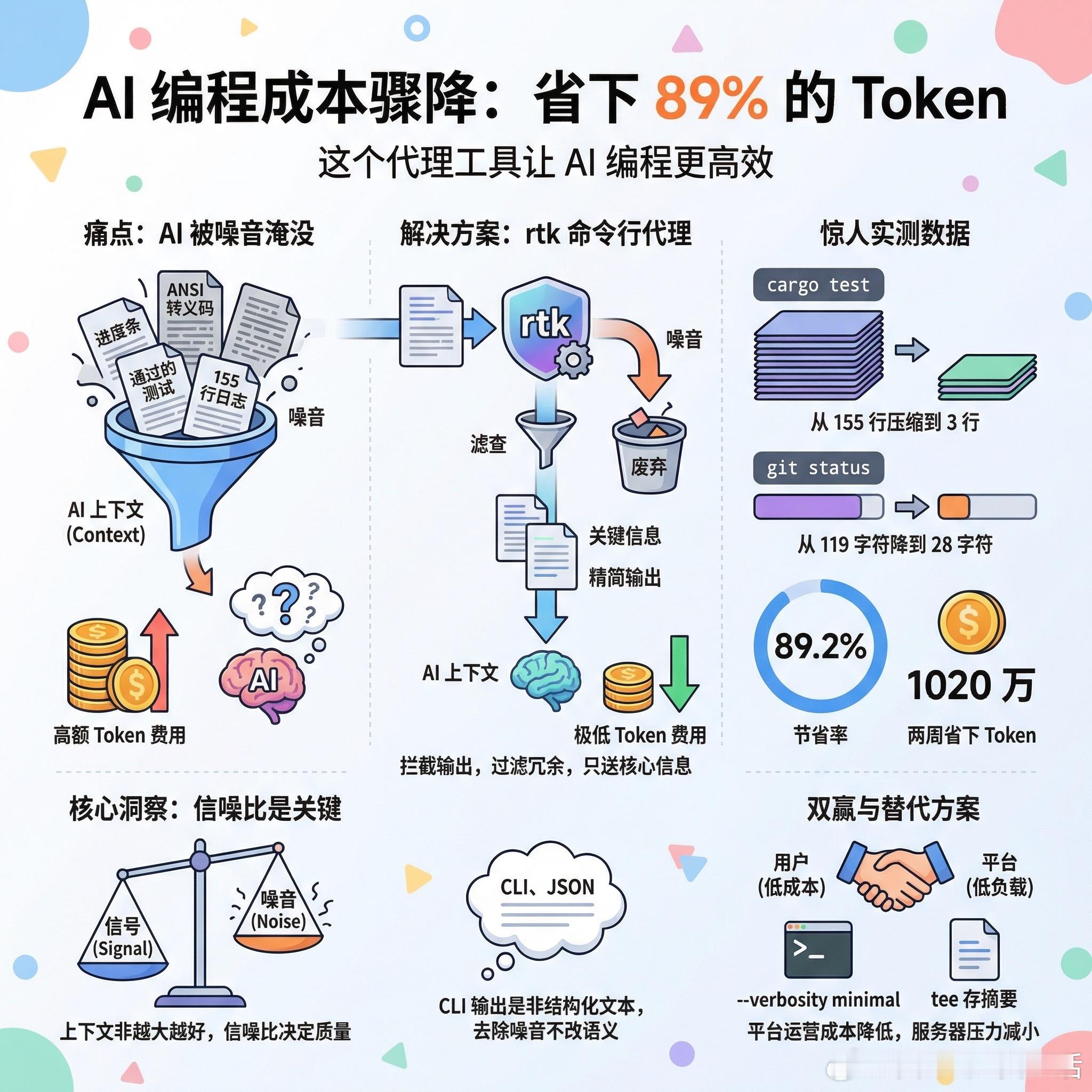

【省下89%的Token,这个代理工具让AI编程成本骤降】

用Claude Code写代码的人都知道一个痛点:AI会把终端输出原封不动地塞进上下文。跑一次测试,155行日志;查一下git状态,119个字符。大部分是通过的测试、进度条、ANSI转义码这些“噪音”,但你得为每一个token买单。

有开发者用Rust写了个叫rtk的命令行代理,专门解决这个问题。原理很简单:拦截命令输出,过滤掉冗余信息,只把AI真正需要的部分送进上下文。

实测数据相当惊人:cargo test从155行压缩到3行,git status从119字符降到28字符。两周下来,省了1020万token,节省率89.2%。

社区讨论中最有价值的质疑来自一篇关于TOON的论文。研究发现,压缩JSON格式后,LLM反而会花更多token去理解陌生的格式,得不偿失。但有人指出关键区别:JSON是LLM熟悉的结构化格式,改动会造成真正的困惑;而CLI输出本来就是给人看的非结构化文本,没有什么“标准格式”可言。去掉噪音不等于改变语义。

这里藏着一个更深的洞察:我们习惯性地把所有信息都喂给AI,以为“多多益善”。但上下文窗口不是越大越好,信噪比才是关键。一个塞满冗余信息的上下文,可能比精简的上下文产生更差的输出。

有人问Anthropic会不会反对这种工具。答案恰恰相反:大多数用户付的是固定月费,token效率越高,Anthropic的运营成本越低,服务器压力越小,反而是双赢。

当然也有更简单的替代方案:在Makefile里给命令加上--verbosity minimal参数,或者在CLAUDE.md里写明让AI用tee把完整日志存到文件、只读取摘要。工具只是手段,核心思路是一样的:别让AI淹没在它不需要的信息里。

GitHub: github.com/rtk-ai/rtk

reddit.com/r/ClaudeAI/comments/1r2tt7q/i_saved_10m_tokens_89_on_my_claude_code_sessions