[CL]《Are Language Models Efficient Reasoners? A Perspective from Logic Programming》A Opedal, Y Zengaffinen, H Shirakami, C Pasti... [ETH Zürich & EPFL] (2025)

语言模型是高效推理者吗?——逻辑编程视角

近年来,大型语言模型(LMs)展现了强大的演绎推理能力,但现有评测多聚焦于正确性,忽视了人类推理重要的“效率”维度。现实推理场景中,大量信息往往无关紧要,推理的关键是识别并忽略这些干扰信息。

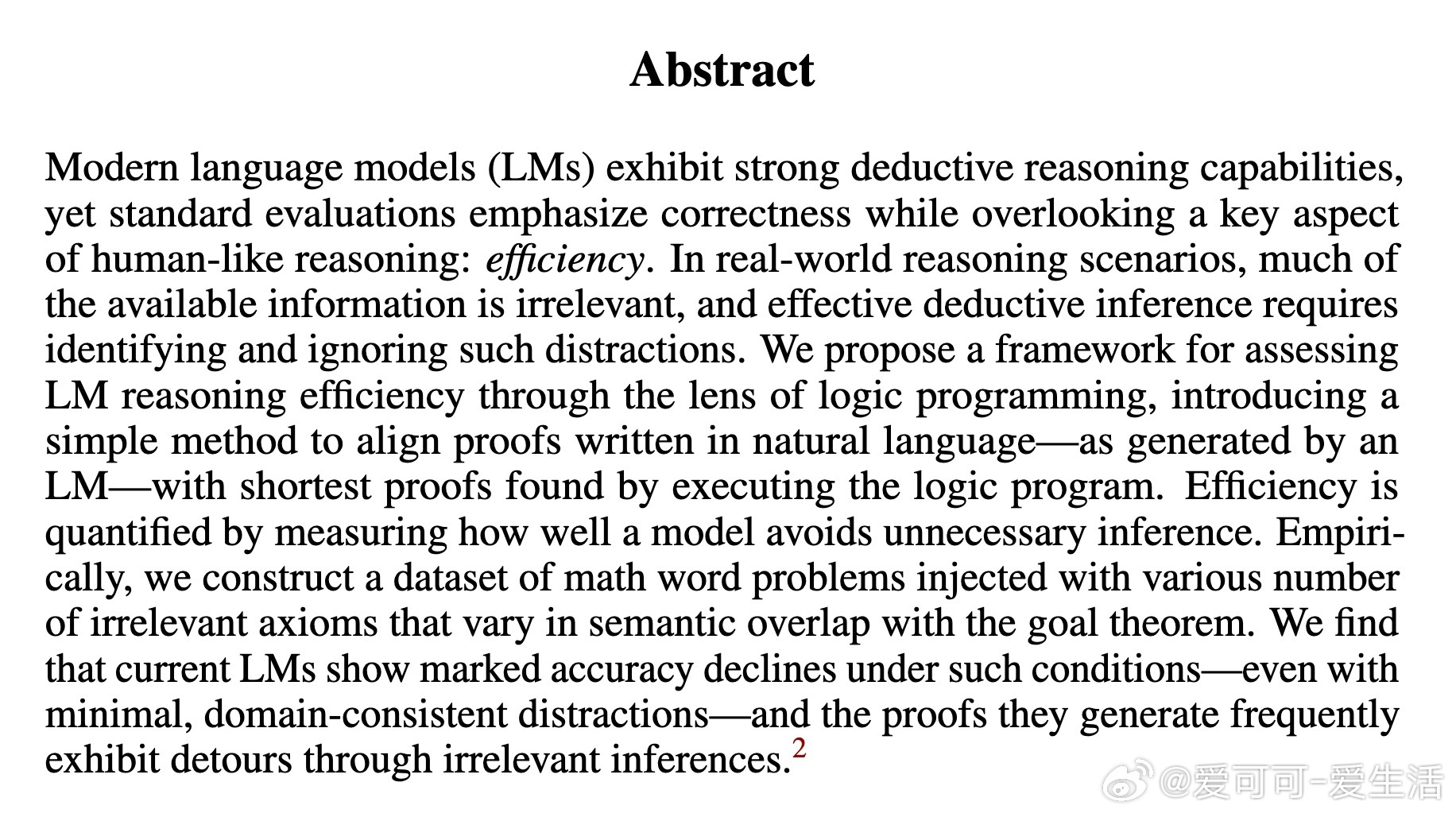

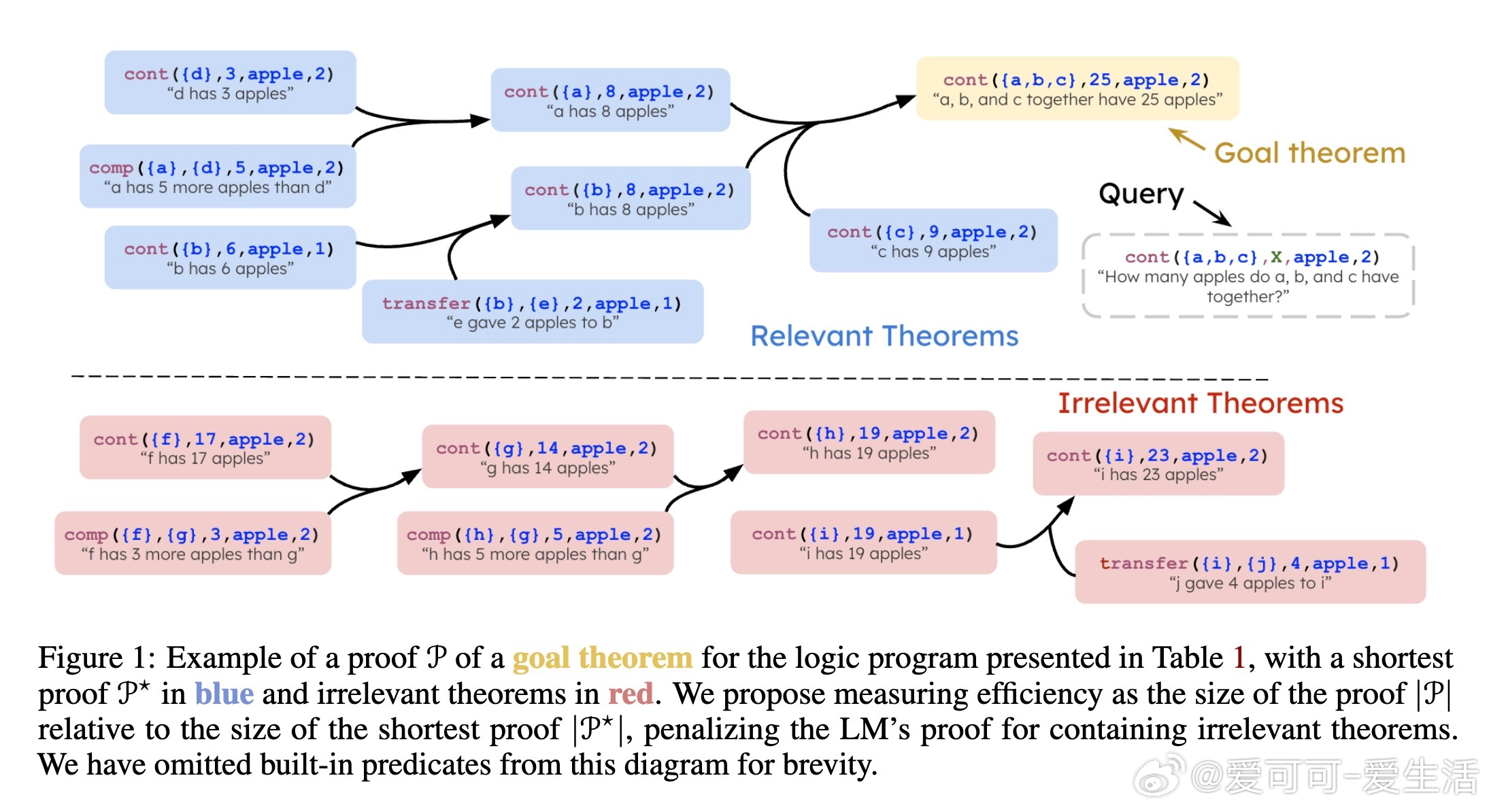

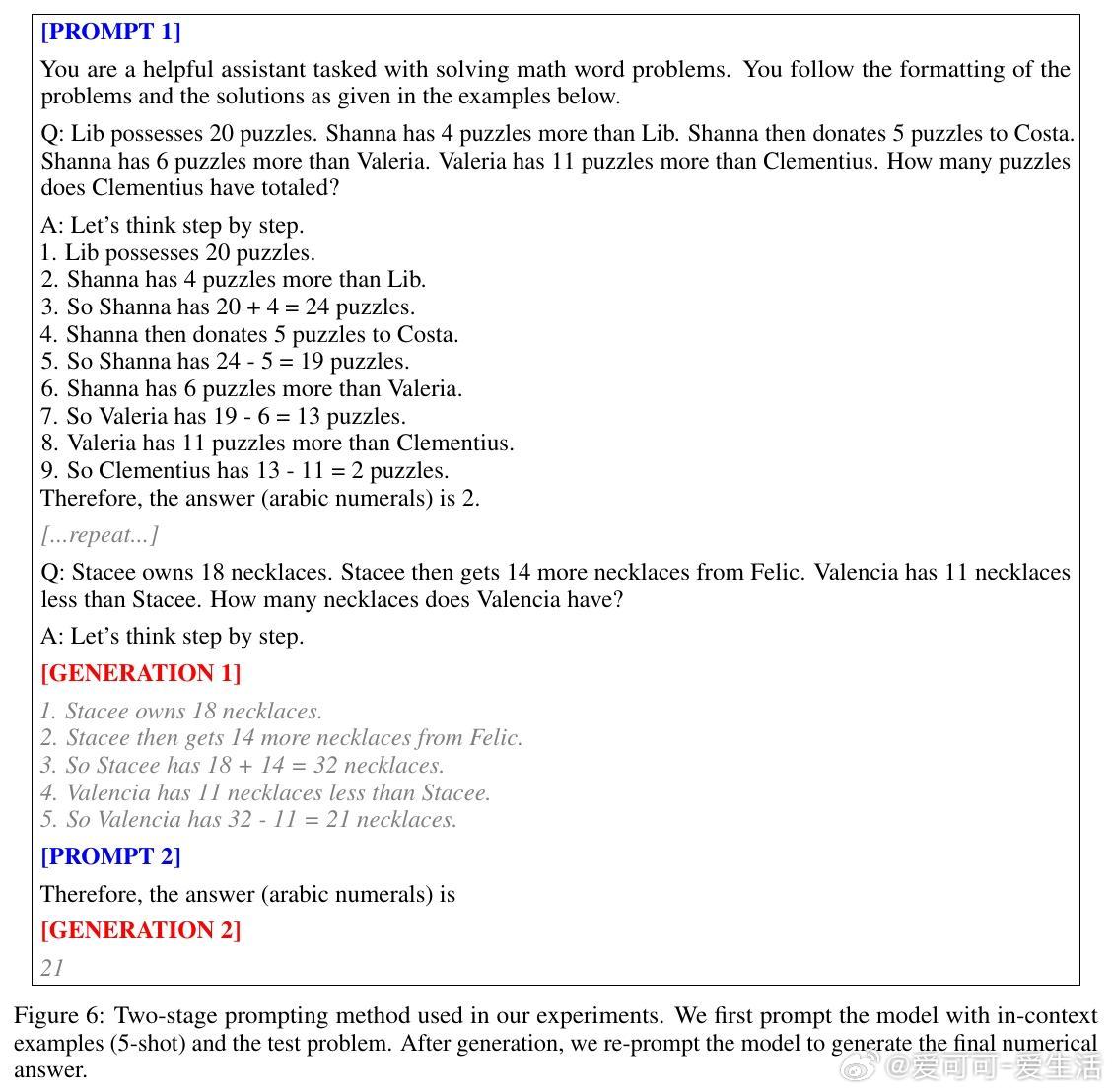

本文创新性地引入逻辑编程框架,提出评估语言模型推理效率的新方法:通过“口头化逻辑程序”将自然语言中的推理过程映射到逻辑程序中的最短证明路径,效率由模型避免不必要推理步骤的能力来量化。

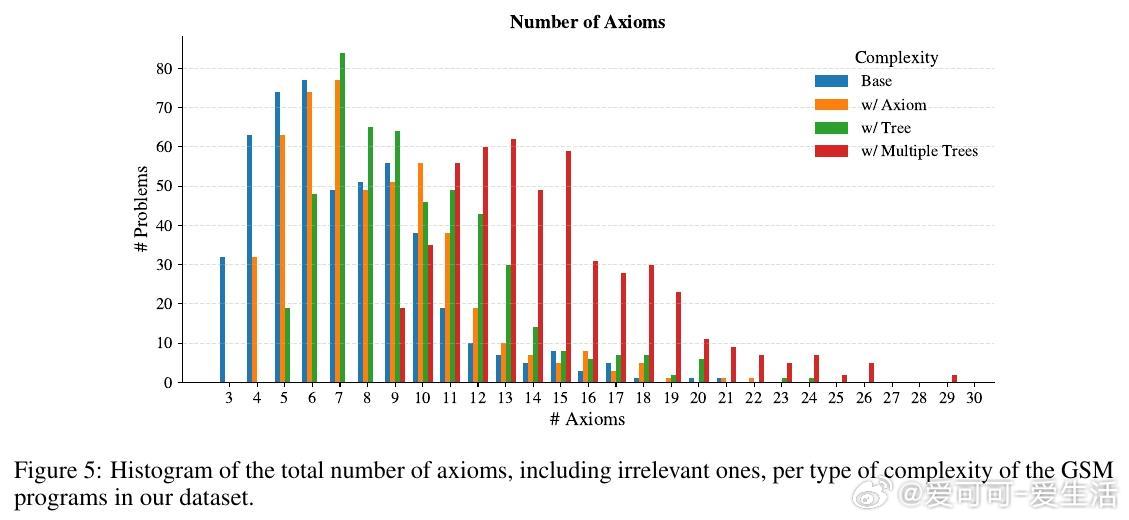

实验设计基于小学数学文字题(GSM),构建含有不同数量和语义重叠程度的无关公理的推理问题。结果显示:

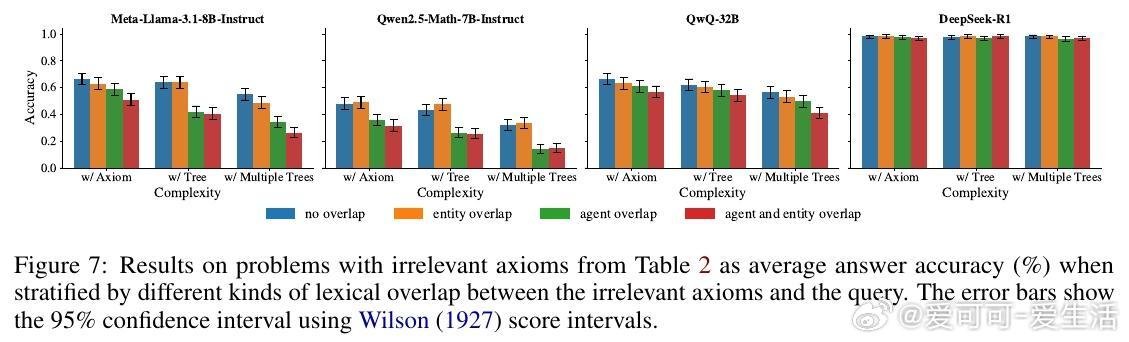

1. 即使是少量语义相关的无关公理,也显著降低模型的准确率,且问题复杂度增加时表现更差。

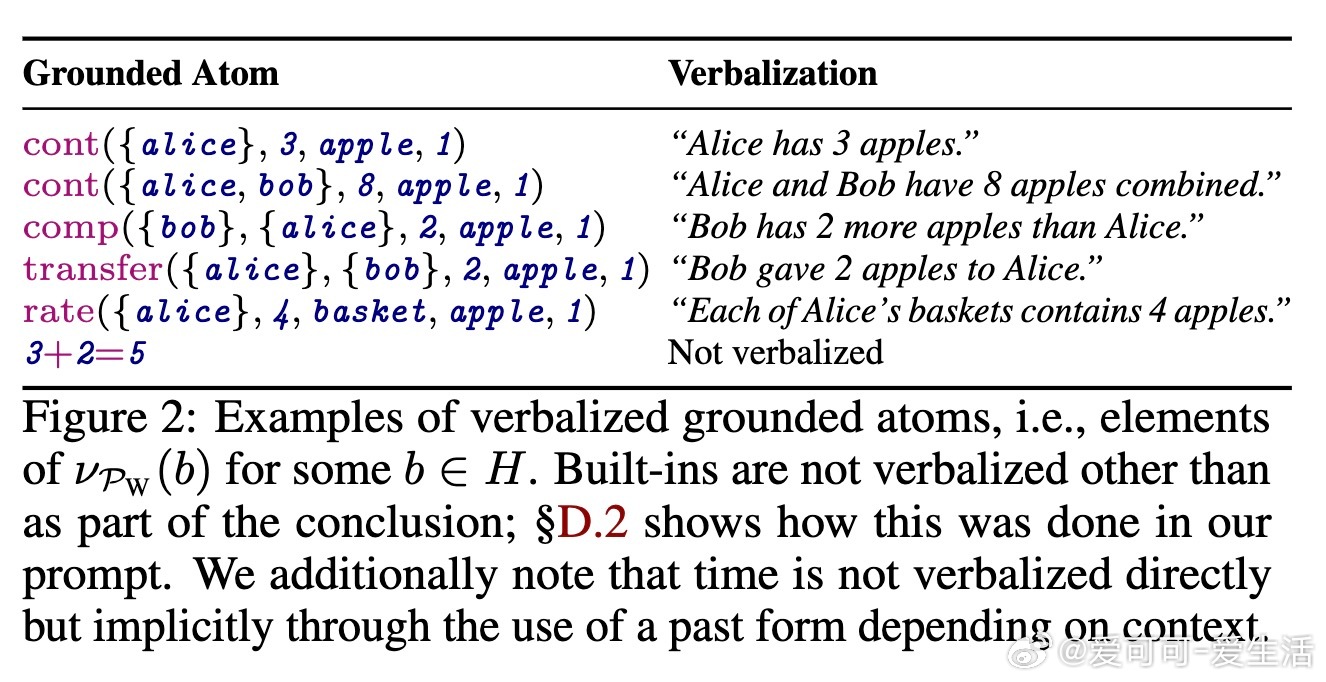

2. 语言模型生成的证明往往包含大量无关推理步骤,效率远低于最短证明。

3. 模型在面对与查询词汇有重叠的无关信息时尤为低效,表明模型的内部搜索部分依赖词汇重叠启发式,但该启发式不完美。

技术细节上,本文:

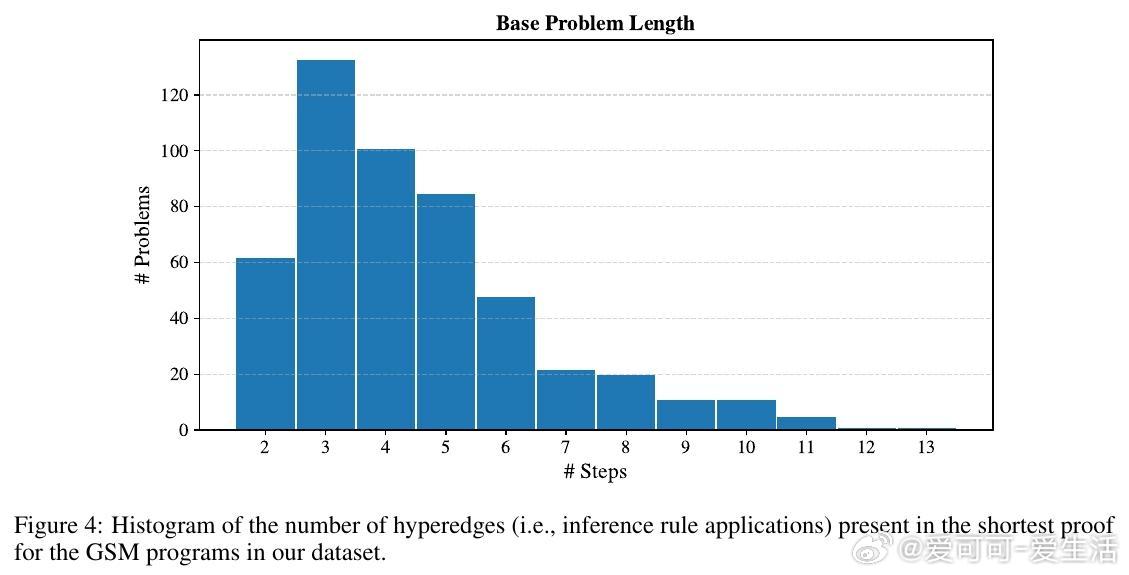

- 利用超图和超路径的数学工具,将逻辑推理问题形式化为寻找超图中最短超路径。

- 设计了一套可解析自然语言推理为逻辑程序证明的“口头化逻辑程序”,有效桥接形式推理与自然语言。

- 通过前向链推理算法,自动生成且保证唯一最短的证明路径作为基线。

- 构建了包含无关信息的数学问题集,严格控制无关公理的语义重叠与结构复杂度,实现对推理效率的细粒度分析。

结论强调:当前语言模型虽能正确推理,但缺乏筛除无关信息的能力,推理效率亟待提升。逻辑编程视角为理解和改进语言模型的推理机制提供了理论和实践工具。

全文与代码见:

语言模型 推理效率 逻辑编程 数学题 机器学习 人工智能