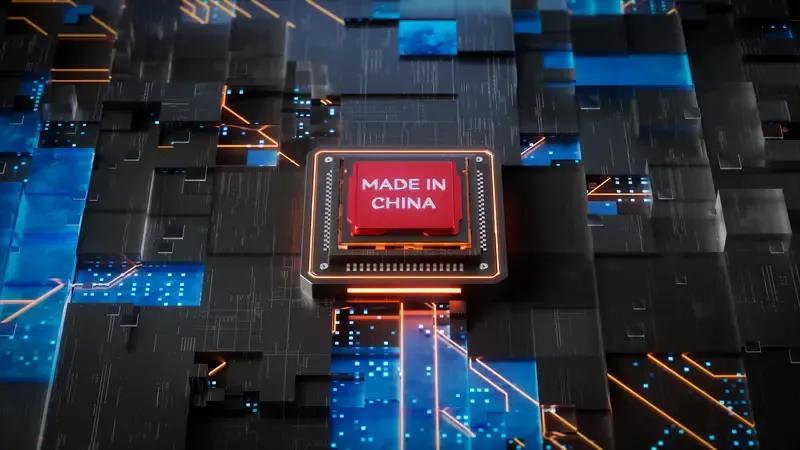

最近很多人都在问,原本说好要亮相的DeepSeek R2咋还没动静?官方没正式说明,但最近圈里传的一些消息,倒也能拼出点轮廓。 直接点说,最表层的原因是团队对当前版本的性能不太满意。就像你辛辛苦苦做了道菜,端上桌前尝一口,发现盐放多了或者火候不够,那肯定得回锅再捣鼓捣鼓。据接触过内测的人说,R2原本定的目标是让模型在复杂逻辑推理和多轮对话里更“聪明”,但现在测试下来,有些场景下的输出还不够稳定,所以开发团队正集中精力调参数、优化算法,想把这块短板补上。 再往深里挖,有个更现实的问题——芯片。国内有消息说,R2的训练进度多少受了点硬件限制,特别是英伟达H20芯片的供应。这芯片大家都不陌生,最近一年多国内大模型厂商或多或少都为它头疼过,毕竟算力是AI模型的“粮草”,没足够的算力支撑,再牛的算法也跑不起来。不过话说回来,5月的时候官方倒是放了个“小惊喜”:原本说是“小版本更新”的R1-0528升级版,实测表现直接让人惊掉下巴。好多人拿它和GPT-o3-high对比,发现不管是写代码、答专业题,还是处理长文本,这升级版的R1居然能打个平手甚至局部反超。这哪是“小版本”?分明是给R1装了台“加速器”。 有人可能会想,既然R1升级版这么强,R2是不是更值得等?还真别说,延期这事现在看反而像是个“好事”。你想啊,要是急着把还不成熟的产品推出来,用户用着卡壳、体验拉胯,反而伤口碑。现在多花时间打磨,把该解决的问题解决了,等R2真出来,那才是“稳稳的幸福”。 圈里还有个传言挺有意思:这次R2的训练可能换了“新装备”——华为昇腾芯片。要是这消息靠谱,那缺芯片的难题说不定能解决大半。华为前阵子公布的“超节点”技术,能把384个GPU、CPU、NPU像搭积木似的连起来,组成一个超大型计算矩阵。懂行的人说,这技术比英伟达的NVL72还强,算力密度和效率都能上一个台阶。要是R2真能用上这套方案,训练速度和模型效果怕是要再上一个层级。 咱们普通用户其实不关心这些技术细节,就盼着能用上更顺手的AI工具。之前用R1的时候,虽然大部分时候挺好用,但偶尔遇到特别绕的问题,它要么回答得不够透彻,要么需要多追问两轮。要是R2能把这些问题解决了,不管是上班写报告、学生做作业,还是平时闲聊解闷,体验肯定能再往上提一截。 说到底,AI模型这东西,就像手机系统更新——有时候看着是“延期”,其实是开发团队在憋大招。与其急着推个“半成品”,不如把底子打扎实了,让用户用着省心、放心。 亲爱各位读者你们怎么看?欢迎在评论区留言讨论!