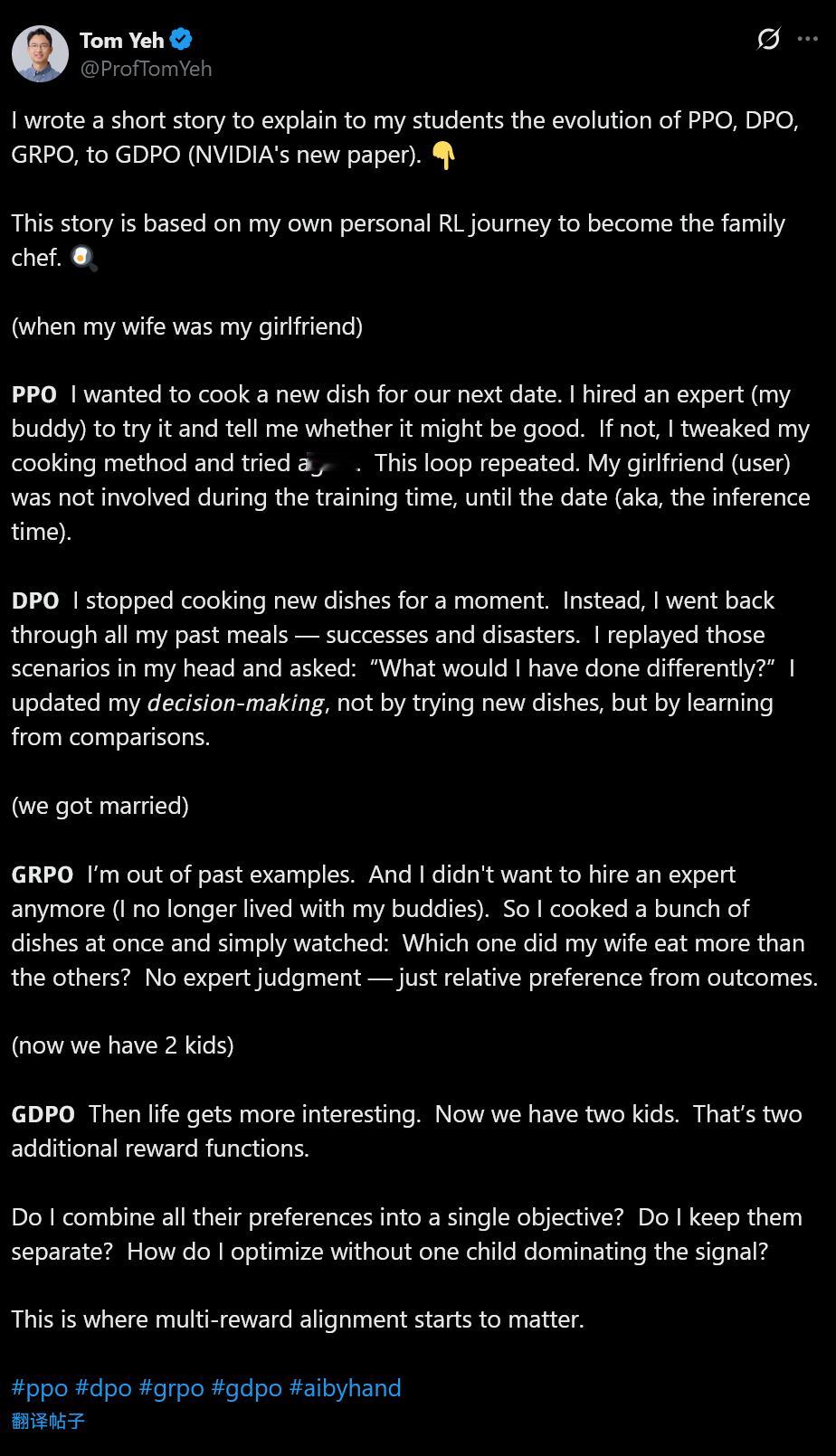

Tom Yeh(用Excel来解释大模型的那个)写了一篇解释 PPO、DPO、GRPO 到 GDPO的短文,翻译下:------------------------------------为了向学生们解释 PPO、DPO、GRPO 到 GDPO(NVIDIA 的新论文)的演变过程,我写了一个短篇故事。故事取材于我自己为了成为“家庭大厨”而经历的强化学习(RL)之旅。(当我的妻子还是我女朋友时)𝗣𝗣𝗢 我想为我们的下次约会做一道新菜。我请了一位专家(我哥们)来试吃,并告诉我这菜行不行。如果不行,我就微调烹饪方法再试一次。这个循环不断重复。而在训练期间,我的女朋友(用户)并不参与,直到约会那天(也就是推理时刻 inference time)她才出现。𝗗𝗣𝗢 我暂时停止了开发新菜式。相反,我回顾了所有做过的饭菜——无论是成功的佳肴还是失败的“惨剧”。我在脑海中重演那些场景并自问:“当时如果那样做会不会更好?” 我通过比较来学习,从而更新我的决策逻辑,而不是通过尝试新菜。(我们结婚了)𝗚𝗥𝗣𝗢 过去的案例已经用完了。我也不想再请专家了(我不再和哥们住一起了)。所以我一次性做了好几道菜,然后静静观察:哪道菜老婆吃得最多?这里没有专家的评判——只有基于结果的相对偏好。(现在我们要了两个孩子)𝗚𝗗𝗣𝗢 生活变得更有趣了。现在我们要了两个孩子。这意味着增加了两个额外的奖励函数(reward functions)。我是该把他们所有的偏好合并成一个单一目标吗?还是把它们分开处理?我要如何优化,才能避免让其中一个孩子的喜好主导了整个反馈信号?这就是多重奖励对齐(multi-reward alignment)开始发挥作用的地方。-------------------------这里的术语: PPO: Proximal Policy Optimization (近端策略优化) — 传统的 RL,依赖奖励模型(哥们/专家)。 DPO: Direct Preference Optimization (直接偏好优化) — 省去奖励模型,直接从历史偏好数据中学习。 GRPO: Group Relative Policy Optimization (群体相对策略优化) — DeepSeek-V3/R1 使用的方法,通过生成多个结果并比较相对好坏来学习,无需额外的价值网络。 GDPO: Group Direct Preference Optimization (群体直接偏好优化) — NVIDIA 提出的新方法,处理多目标/多维度的偏好对齐。HOW I AI